Chaque nouvelle introduction de produit suit un scénario prévisible. La conception du tableau est verrouillée. Le stencil est découpé. Les composants sont assemblés. Ensuite, le profilage de réchauffage commence, et une semaine disparaît. Les ingénieurs poursuivent la courbe du profil de rampes, soak, spike du manuel, en itérant sur plusieurs passages dans le four, en ajustant la température des zones par incréments d’un quart de degré, et en assistent à l’accumulation de passifs tombés en tombstone et de joints froids. La date de lancement est repoussée. Le cycle recommence pour le projet suivant.

Ce gaspillage n'est pas le résultat d'une diligence insuffisante ou d'un équipement mal calibré. C'est la conséquence prévisible de l'application d'un profil théorique à un assemblage qui viole sa principale hypothèse : une masse thermique homogène. Le profil du manuel n'a jamais été conçu pour une carte portant à la fois un connecteur d'alimentation massif et une grille de résistances 0402. Il suppose une charge thermique homogène que de vrais produits affichent rarement. Lorsqu'il y a une masse thermique inégale, un seul profil ne peut satisfaire aux fenêtres de processus conflictuelles des composants lourds et légers. Optimiser pour l’un garantit l’échec de l’autre.

La solution n’est pas une meilleure estimation. C’est un passage à un profilage enregistré par data-logging, une cartographie disciplinée du four, et une évaluation sobre du moment où un environnement à l'azote est réellement justifié. Ces pratiques réduisent le cycle d'itération en anticipant la mesure et en respectant la physique du transfert de chaleur. Elles remplacent la semaine d’essais et d’erreurs par une méthodologie qui fonctionne dès la première mise en œuvre.

La semaine où vous perdez à poursuivre le profil du manuel

Le profil de réadaptation du manuel est séduisant par sa simplicité : une montée contrôlée pour activer le flux, une immersion pour égaliser la température, un spike au-dessus du liquide pour mouiller la soudure, et un refroidissement contrôlé pour former la jointure. La courbe est fluide, les phases sont distinctes, et la théorie est solide. Elle semble ingénieuse. Elle semble sûre. Et elle est à l'origine d'une semaine d'efforts inutiles.

Le flux de travail qu’elle génère n’est en rien sûr. Un profil initial est programmé selon la recommandation du fabricant de pâte, lui-même une idéalisation qui ne précise rien sur la densité des composants ou sur le poids du cuivre. La carte est lancée. L’inspection révèle un catalogue familier de défauts : tombstone sur de petits passifs proches du bord, mauvaise mise en wetting sur les broches de masse d’un grand connecteur, ou pire, pads soulevés par choc thermique. L’ajustement du profil est alors réalisé. La soak est prolongée pour donner plus de temps au composant lourd pour chauffer. La carte est lancée à nouveau. Maintenant, les petits composants sont brûlés. Un autre ajustement. Une autre mise en marche. D’ici vendredi, le profil du four est un Frankenstein de compromis, chaque température de zone étant une négociation entre des exigences contradictoires.

La persistance de cette approche n’est pas due à l’ignorance. Elle est enseignée dans chaque cours d’assemblage, publiée dans toutes les fiches techniques de pâte à souder, et intégrée dans le modèle mental de ce qu’est censé être le profilage. L’hypothèse qu’une seule courbe peut être optimisée pour une carte entière est rarement remise en question parce qu’elle est rarement formulée. C’est simplement ainsi que c’est fait.

Cette hypothèse est une erreur de catégorie. Le profil du manuel a été dérivé pour des assemblages simples où la masse thermique est contrôlée. Les véritables cartes de production sont thermiquement chaotiques. Un backplane avec un champ de connecteurs dense et des plans de masse inondés présente une pièce thermique qui a besoin de 30 secondes pour atteindre la température de soak. Les condensateurs 0402 situés à 50 millimètres, sur des pads isolés, atteignent cette même température en huit secondes. Aucun taux de montée ou durée de soak unique ne peut satisfaire les deux. Le manuel ne reconnaît pas ce conflit parce qu’il ne le modélise pas.

Pourquoi la masse thermique tue les profils universels

La physique du chauffage inégal

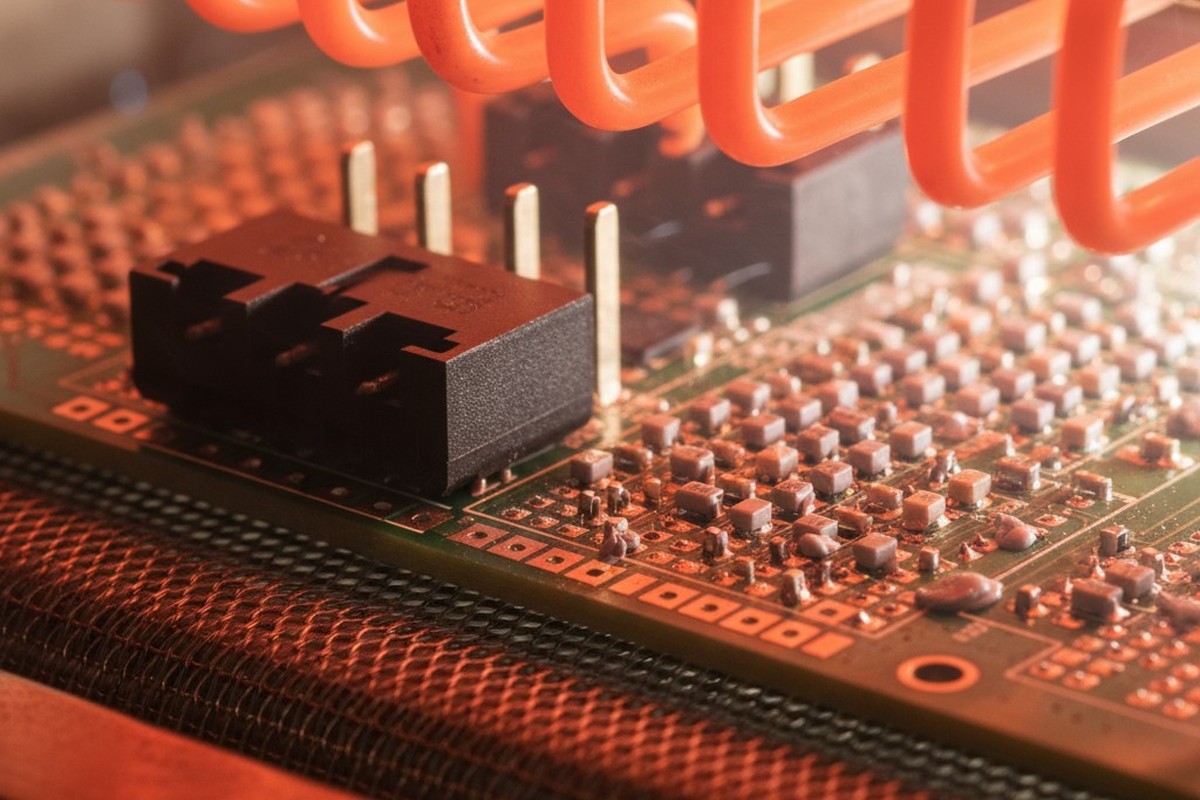

En flux inversé, la masse thermique est la capacité d’un composant à absorber et retenir la chaleur. Un grand connecteur en cuivre et en plastique a une masse thermique élevée ; il se réchauffe lentement et résiste aux variations de température. Un petit condensateur en céramique a une masse thermique faible ; il réagit presque instantanément à l’environnement du four. Ces deux pièces ne chaufferont jamais à la même vitesse.

Le transfert de chaleur dans un four à convection est entraîné par l’air forcé. La vitesse à laquelle un composant absorbe de l’énergie dépend de sa surface, de sa conductivité thermique, et de la différence de température entre celui-ci et l’air environnant. Un grand connecteur avec une masse significative mais une surface exposée limitée chauffe lentement. Un petit passif avec un rapport surface-masse élevé chauffe rapidement. La carte elle-même, en particulier les zones avec de grandes couches de cuivre, agit comme une réserve thermique qui complique davantage la vitesse de chauffage des composants proches.

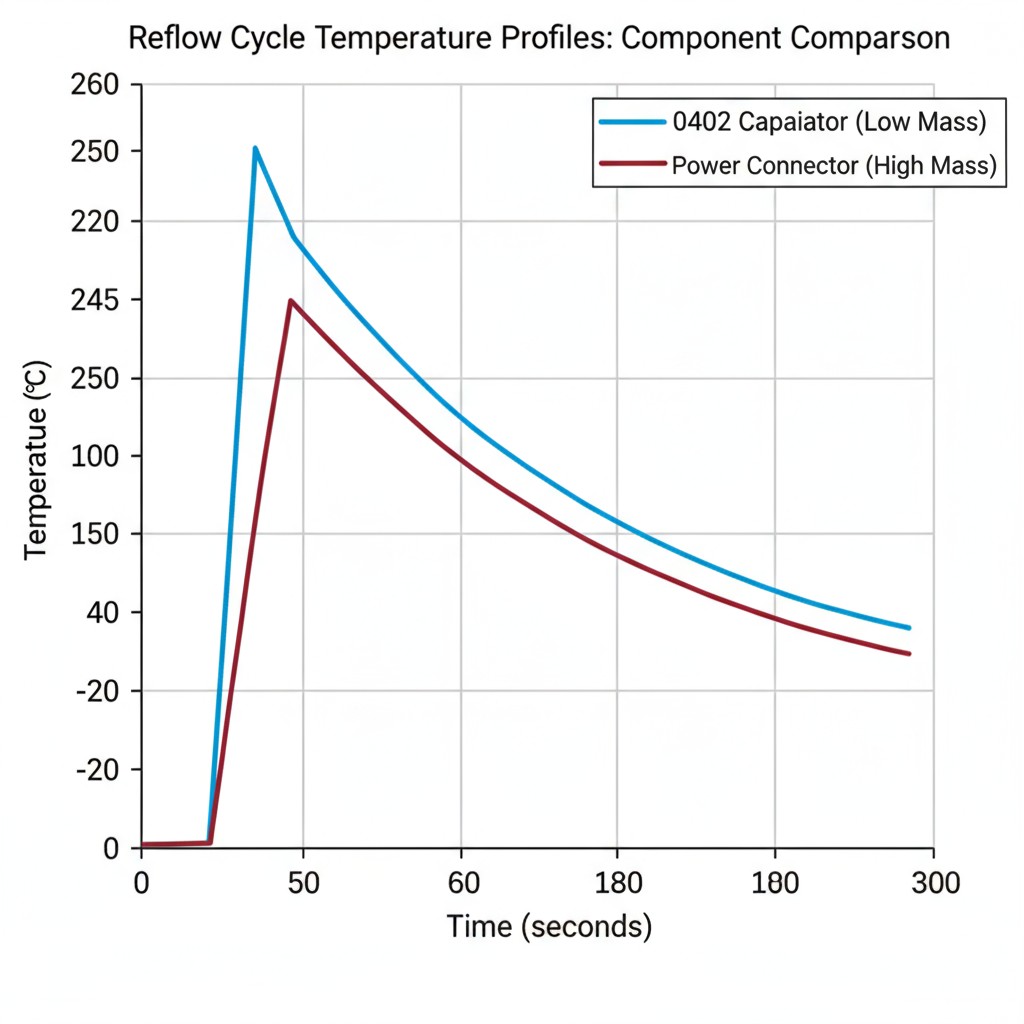

Le résultat est une carte en désordre thermique. À tout moment, les composants ont des températures très différentes. Lorsque les petites passives sont à 200°C et prêtes pour le pic jusqu'au liquideus, le connecteur lourd peut encore être à 160°C. Lorsque le four est monté en puissance pour donner à ce connecteur suffisamment d'énergie pour atteindre la température de pic, les petites passives subissent un temps de séjour prolongé et dommageable au-dessus du liquideus.

Les fenêtres de processus conflictuelles

Chaque composant possède une fenêtre de processus — une plage de temps et de température qui produit une jointure de soudure fiable sans causer de dommages. Pour une petite résistance 0402, cette fenêtre est étroite ; elle peut tolérer un bref spike au-dessus du liquideus, mais une chaleur prolongée fissurera son corps ou dégradera ses terminaisons. Pour un grand connecteur, la fenêtre est définie par le temps minimum nécessaire pour mouiller ses broches massives et le temps maximum avant que son boîtier en plastique ne déforme.

Un profil de refusion unique est une tentative de trouver un compromis qui maintient tous les composants dans leurs fenêtres respectives. Lorsque la masse thermique est inégale, ce compromis n'existe pas.

Considérez une carte avec un connecteur d’alimentation à 40 broches et un champ de petites passives. Le connecteur exige une longue immersion et une température de pic soutenue. Programmer le four pour cela garantit que les passives seront trop cuites. Réduire le profil pour protéger les passives garantit des joints froids sur le connecteur.

Les défauts sont prévisibles. Le tombstone se produit lorsque l’un des extrémités d’une passive refuse avant l’autre, permettant à la tension de surface de la tirer verticalement — un résultat direct d’un profil trop agressif pour les pièces à faible masse. Les joints de soudure froids sur de gros composants représentent le problème inverse : la masse thermique du composant a absorbé toute la chaleur avant que la soudure ne puisse mouiller correctement la patte. Tenter de corriger un défaut produit de manière fiable l’autre. Il ne s’agit pas d’un problème d’ajustement ; c’est une inadéquation fondamentale entre le paradigme de courbe unique et la réalité thermique.

La discipline de profilage enregistrée par data-logging

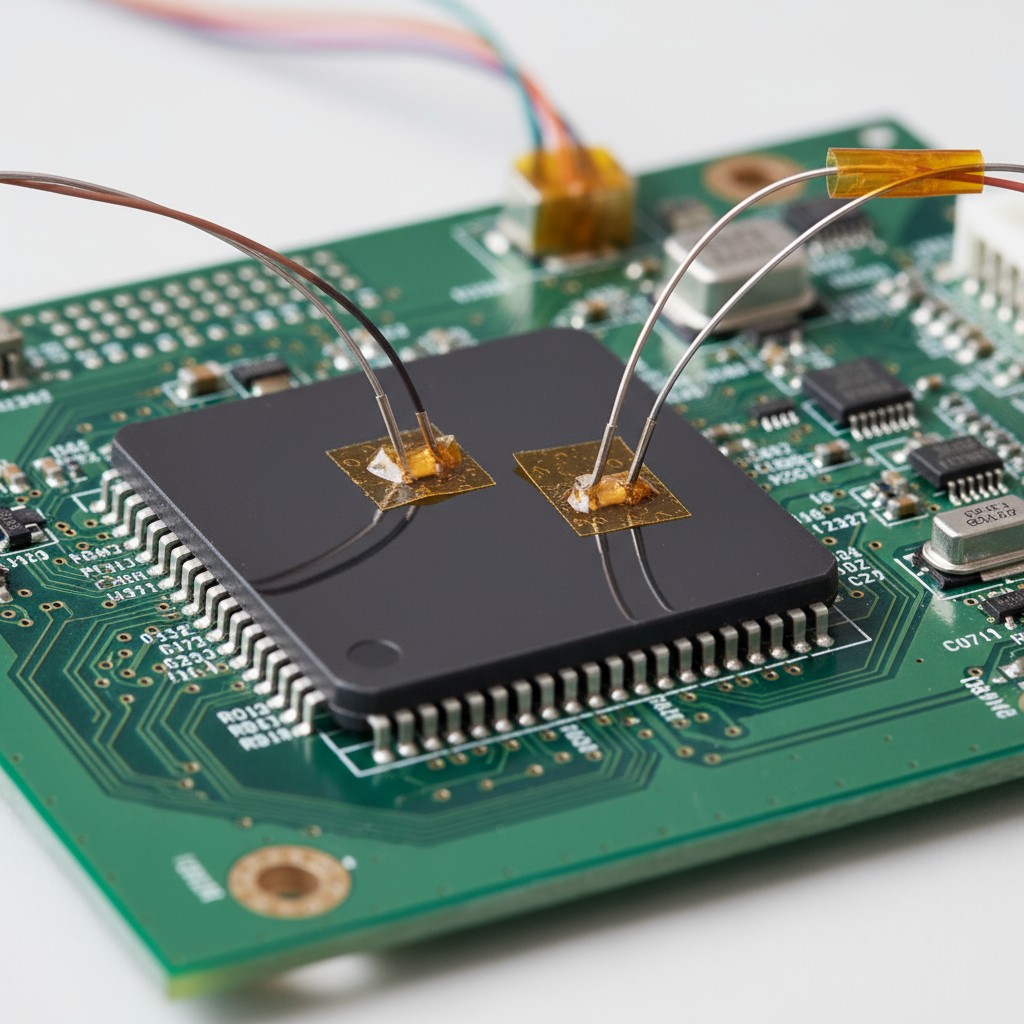

L’alternative à supposer qu’un profil fonctionnera est de vérifier si c’est le cas. Le profilage avec enregistrement de données utilise des thermocouples directement attachés aux composants aux extrêmes thermiques de la carte : la pièce à masse maximale et la plus faible. Faire passer la carte dans le four enregistre la température réelle que chaque composant subit dans le temps. Cela vous donne un récit factuel de ce qui se passe, pas une prédiction théorique.

La valeur ici n’est pas une courbe plus esthétique. C’est la révélation sans ambiguïté de l’endroit où les fenêtres de processus sont violées. Lorsque les données montrent que la petite passive atteint 250°C alors que le grand connecteur a encore du mal à 210°C, les suppositions cessent. Le conflit est quantifié. La décision devient une question de priorisation. Souvent, le composant lourd doit dicter le profil, et les composants plus légers doivent être protégés par d’autres moyens, comme le placement sur la carte ou le pré-chauffage des zones.

Le profilage avec enregistrement de données démolit également la fausse confiance qui vient de mesurer la température de l’air du four ou d’utiliser une carte nue. La température de l’air indique ce que fait le four, pas ce que ressentent les composants. Une carte nue n’a aucune variation de masse thermique, ce qui rend son profil une fiction idéalisée. Seule la mesure à l’échelle des composants capture la vérité. Cette discipline nécessite un investissement initial, mais ce coût est récupéré la première fois qu’un NPI n’a pas besoin de cinq séries de tests.

La question de l'azote que personne ne pose correctement

L’atmosphère d’azote pendant le refusement est spécifiée avec une cohérence remarquable et remise en question avec une rareté remarquable. La supposition est qu’un environnement inerte est toujours meilleur. La réalité est plus conditionnelle. L’azote inhibe l’oxydation de la soudure fondue, ce qui n’est bénéfique que si la chimie du flux est trop faible pour faire le travail seule ou si la finition de surface de la carte est particulièrement sensible.

Lorsqu’il est réellement important : les flux sans nettoyage ont une activité chimique moindre. Sur des finitions comme le cuivre nu ou l’ENIG, où les oxydes se forment rapidement à température de refusion, le flux pourrait ne pas pouvoir nettoyer la surface avant que la soudure ne mouille. Ici, l’azote offre une marge de processus significative.

Lorsque l’azote est inutile : Les flux agressifs solubles dans l’eau sont conçus pour traverser les oxydes. Les utiliser sous azote ne procure aucun avantage supplémentaire. De même, les finitions de nivellement par chaleur à l’air (HASL) sont intrinsèquement exemptes d’oxydes et ne tirent rien d’une atmosphère inerte. La spécification de l’azote dans ces cas augmente les coûts et la complexité sans amélioration mesurable.

La question n’est pas de savoir si l’azote est bon, mais si votre combinaison spécifique de flux et de finition de surface présente un défi d’oxydation que le flux ne peut gérer seul. C’est une décision d’ingénierie des matériaux, pas une spécification générale.

Cartographie du four One-and-Done

La cartographie du four caractérise l’uniformité de la température et le flux d’air de votre four. Une carte de test quadrillée avec des thermocouples est passée dans le processus, révélant des zones chaudes et froides sur le convoyeur. Ces données vous permettent de placer les cartes dans la position optimale et de régler les points de consigne des zones pour compenser la signature thermique unique du four.

La discipline consiste à faire cela en profondeur, une seule fois, et à considérer les données obtenues comme la vérité absolue pour tout le travail ultérieur. La carte n’est pas répétée pour chaque nouvelle planche. Au lieu de cela, elle informe le profil initial de chaque NPI. Vous savez déjà que le côté gauche du convoyeur fonctionne à 10 degrés de plus que le droit, alors vous faites l’ajustement avant que la première planche n’y passe.

Cela élimine la redécouverte itérative des particularités du four. Cela rend la caractérisation du four une étape préalable, et non une réflexion tardive. Le temps investi dans une étude de cartographie complète est de quelques heures. Le temps économisé sur une année de NPI est de plusieurs semaines.

Élaborer un protocole de profilage qui respecte la physique

Rejeter l’orthodoxie doctrine au profit de la mesure mène à un protocole qui anticipe la collecte de données. Il ne vise pas une courbe parfaite. Il vise une fenêtre de processus qui produit des joints acceptables sur chaque composant — un objectif différent et plus réalisable.

Le protocole :

- Cartographiez le four. Si cela n’a pas encore été fait, caractérisez son uniformité thermique. Documentez les points chauds, les points froids et les décalages entre zones.

- Identifiez les extrêmes thermiques. Sélectionnez le composant le plus grand, le plus lourd, et le plus petit, le plus léger sur votre planche. Ce sont vos sentinelles.

- Fixez des thermocouples. Instrumentez les composants sentinelles et faites fonctionner la planche en utilisant un profil initial basé sur les données de pâte et votre carte du four.

- Examinez les données. Vérifiez les courbes de température enregistrées. Les deux sentinelles sont-elles restées dans leur fenêtre de process ? Sinon, ajustez les points de consigne des zones ou la vitesse du convoyeur.

- Confirmer. Exécutez un profil supplémentaire avec les réglages ajustés pour vérifier que les deux sentinelles sont conformes.

- Valider. Inspectez les joints de soudure sur les sentinelles et un échantillon d'autres composants. S'ils sontAcceptables, verrouillez le profil. Si des défauts subsistent, le problème n'est pas le profil ; c'est un problème de conception amont que davantage d'itérations ne résoudront pas.

Ce protocole utilise des données réelles pour guider les décisions et limite la boucle d'itération à une seule exécution de confirmation. Le temps économisé est le résultat direct de refuser de deviner quand vous pouvez mesurer.