Jede neue Produkteinführung folgt einem vorhersehbaren Skript. Das Platinen-Design ist gesperrt. Die Schablone ist ausgeschnitten. Die Komponenten sind bestückt. Dann beginnt das Reflow-Profiling, und eine Woche verschwindet. Ingenieure jagen der textbook Kurve von Ramp-Soak-Spike nach, iterieren durch Ofenläufe, passen die Zonentemperaturen in Viertel-Grad-Schritten an und beobachten, wie Tombstoned-Passive und kalte Lötstellen sich anhäufen. Das Startdatum rückt in die Ferne. Der Zyklus wiederholt sich im nächsten Projekt.

Dieses Verschwendung ist nicht das Ergebnis unzureichender Sorgfalt oder schlecht kalibrierter Geräte. Es ist die vorhersehbare Folge der Anwendung eines theoretischen Profils auf eine Baugruppe, die ihre Kernannahme verletzt: eine einheitliche thermische Masse. Das textbook-Profil wurde nie für eine Platine entworfen, die sowohl einen massiven Stromanschluss als auch ein Gitter aus 0402-Widerständen trägt. Es nimmt eine homogene thermische Last an, die reale Produkte nur selten aufweisen. Wenn die thermische Masse ungleichmäßig ist, kann ein einzelnes Profil die widersprüchlichen Prozessfenster schwerer und leichter Komponenten nicht erfüllen. Die Optimierung für eine garantiert Versagen bei der anderen.

Die Lösung ist keine bessere Schätzung. Es ist ein Wechsel zu data-logged Profiling, diszipliniertem Ofen-Mapping und einer nüchternen Bewertung, wann eine Stickstoffatmosphäre wirklich gerechtfertigt ist. Diese Praktiken verkürzen die Iterationsschleife durch Vorab-Messungen und die Berücksichtigung der Physik des Wärmeübergangs. Sie ersetzen die Woche Trial-and-Error durch eine Methodik, die beim ersten Lauf funktioniert.

Die Woche, in der Sie dem Textbook-Profil hinterherjagen

Das textbook-Reflow-Profil ist verführerisch in seiner Einfachheit: ein kontrollierter Anstieg, um das Flussmittel zu aktivieren, ein Soak, um die Temperatur auszugleichen, ein Spike über die Flüssigkeitsspiegel, um das Lötzinn zu benetzen, und eine kontrollierte Abkühlung, um die Verbindung zu formen. Die Kurve ist glatt, die Phasen sind deutlich, und die Theorie ist stichhaltig. Es fühlt sich ingenieurmäßig an. Es fühlt sich sicher an. Und es ist die Ursache für eine Woche verschwendeter Mühe.

Der Arbeitsablauf, den es erzeugt, ist alles andere als sicher. Ein initiales Profil wird basierend auf den Empfehlungen des Pastenherstellers programmiert, die selbst eine Idealisierung sind und nichts über Komponenten-Dichte oder Kupfergewicht aussagen. Die Platine wird betrieben. Die Inspektion zeigt eine vertraute Liste von Fehlern: Tombstoning an kleinen Passiven in der Nähe des Randes, schlechte Benetzung an den Massepins eines großen Steckers oder schlimmer noch, hochgezogene Pads durch thermischen Schock. Also wird die Kurve angepasst. Das Soak wird verlängert, um dem schweren Bauteil mehr Zeit zum Aufheizen zu geben. Die Platine wird erneut betrieben. Jetzt sind die kleinen Komponenten verbrannt. Noch eine Anpassung. Noch ein Lauf. Bis Freitag ist das Ofenprofil ein Frankenstein aus Kompromissen, jede Zonentemperatur eine verhandelte Einigung zwischen widersprüchlichen Anforderungen.

Die Persistenz dieses Ansatzes ist kein Mangel an Wissen. Es wird in jedem Montagekurs gelehrt, in jedem Lötpaste-Datenblatt veröffentlicht und ist im mentalen Modell verankert, was Profiling sein soll. Die Annahme, dass eine einzelne Kurve für eine gesamte Platine optimiert werden kann, ist selten in Frage gestellt, weil sie selten ausgesprochen wird. Es ist einfach die übliche Vorgehensweise.

Diese Annahme ist ein Kategorienfehler. Das textbook-Profil wurde für einfache Baugruppen entwickelt, bei denen die thermische Masse kontrolliert wird. Reale Produktionsplatinen sind thermisch chaotisch. Ein Rückwand mit einem dichten Steckverbinderfeld und gefluteten Masseflächen stellt eine thermische Senke dar, die 30 Sekunden benötigt, um die Soak-Temperatur zu erreichen. Die 50 Millimeter entfernten 0402-Kondensatoren auf isolierten Pads erreichen diese Temperatur in acht Sekunden. Kein einzelner Anstiegsraten- oder Soak-Dauer kann beide zufriedenstellen. Das textbook erkennt diesen Konflikt nicht an, weil es ihn nicht modelliert.

Warum thermische Masse einheitliche Profile zerstört

Die Physik der ungleichmäßigen Erwärmung

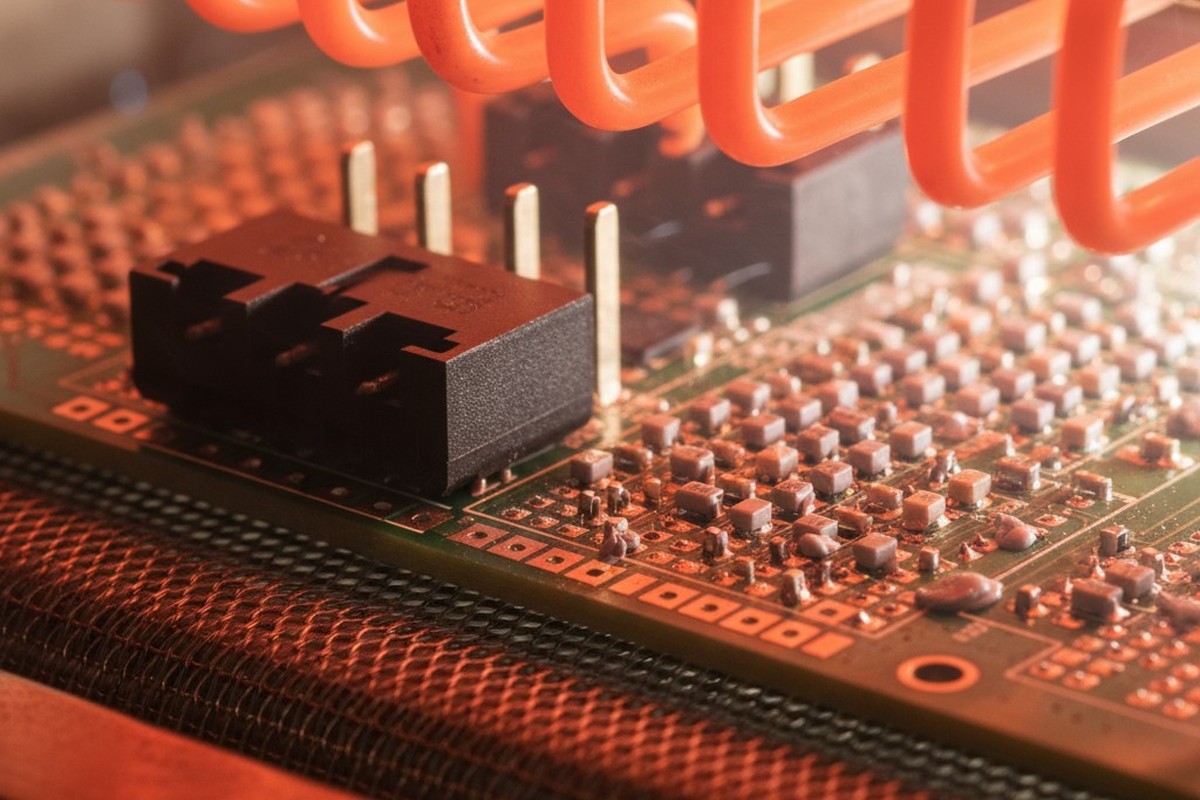

Beim Fließen ist thermische Masse die Fähigkeit einer Komponente, Wärme zu absorbieren und zu halten. Ein großer Kupfer- und Kunststoffanschluss hat eine hohe thermische Masse; er erwärmt sich langsam und widersteht Temperaturschwankungen. Ein winziger Keramikkondensator hat eine niedrige thermische Masse; er reagiert fast sofort auf die Umgebung des Ofens. Diese beiden Teile werden niemals mit der gleichen Rate erhitzen.

Wärmeübertragung in einem Konvektionsofen wird durch Gebläse angetrieben. Die Rate, mit der ein Bauteil Energie absorbiert, hängt von seiner Oberfläche, seiner Wärmeleitfähigkeit und dem Temperaturunterschied zwischen ihm und der umgebenden Luft ab. Ein großes Steckverbinder mit erheblicher Masse, aber begrenzter exponierter Oberfläche, heizt träge. Ein kleines Passive mit einem hohen Oberflächen-zu-Masse-Verhältnis erhitzt sich schnell. Die Platine selbst, insbesondere Bereiche mit starken Kupferflächen, wirkt als thermisches Reservoir, das die Erwärmungsrate benachbarter Komponenten weiter verkompliziert.

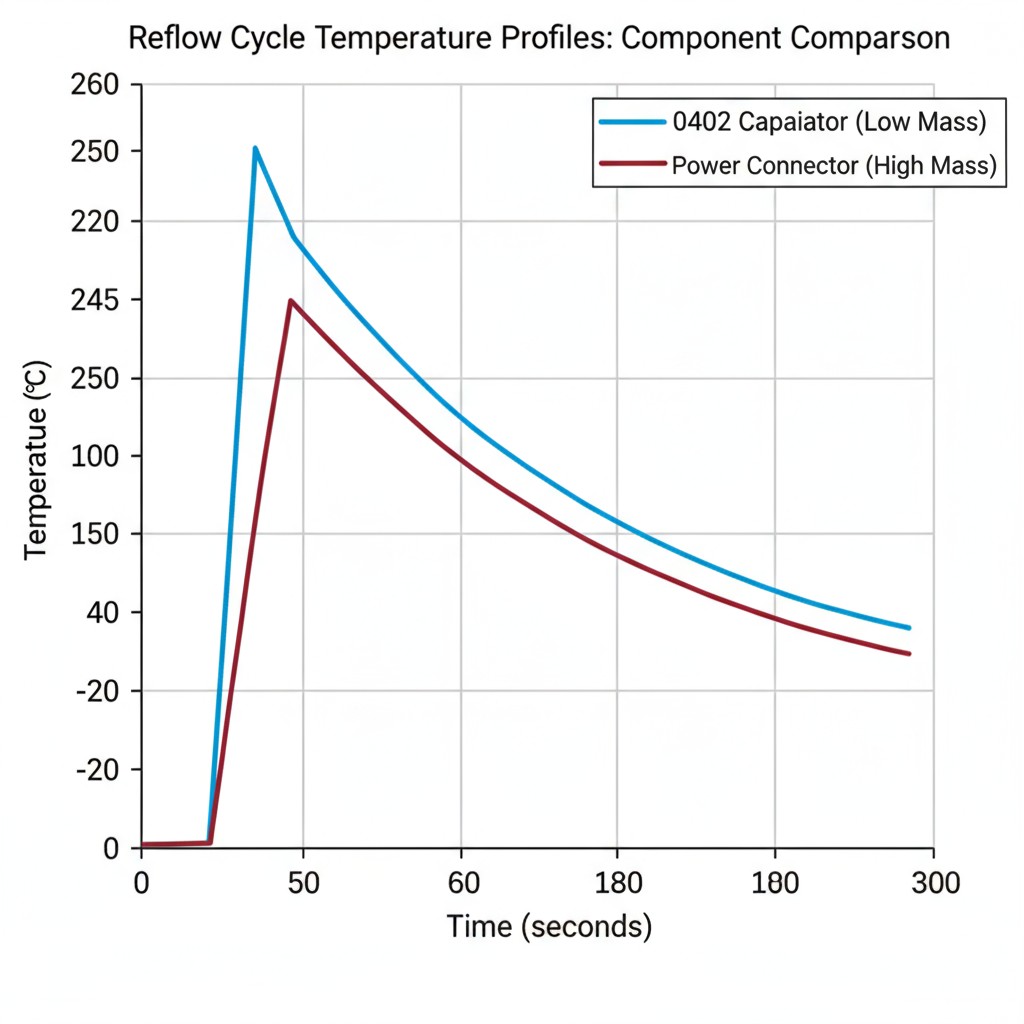

Das Ergebnis ist eine Leiterplatte im thermischen Chaos. In jedem Moment befinden sich die Komponenten bei äußerst unterschiedlichen Temperaturen. Wenn die kleinen Passivbauteile bei 200°C sind und bereit für den Spike auf den Flüssigkeitsgrad, könnte der große Stecker noch bei 160°C sein. Wenn der Ofen aufgedreht wird, um dem Stecker genug Energie zu geben, um die Höchsttemperatur zu erreichen, wird den kleinen Passivbauteilen eine längere, schädliche Verweildauer über dem Flüssigkeitsgrad auferlegt.

Die widersprüchlichen Prozessfenster

Jedes Bauteil hat ein Prozessfenster—eine Spannweite an Zeit und Temperatur, die eine zuverlässige Lötverbindung erzeugt, ohne Schaden zu verursachen. Bei einem kleinen 0402-Widerstand ist dieses Fenster eng; er kann einen kurzen Spike über dem Flüssigkeitsgrad vertragen, aber längere Hitzeeinwirkung wird seinen Körper zerkratzen oder seine Anschlüsse verschlechtern. Bei einem großen Stecker wird das Fenster durch die Mindestzeit zum Benetzen seiner massiven Pins und die maximale Zeit vor der Deformation seines Kunststoffgehäuses definiert.

Ein einzelnes Reflow-Profil ist ein Versuch, einen Kompromiss zu finden, der alle Komponenten innerhalb ihrer jeweiligen Fenster hält. Wenn die thermische Masse ungleichmäßig ist, existiert dieser Kompromiss nicht.

Betrachten Sie eine Leiterplatte mit einem 40-poligen Stromanschluss und einem Feld kleiner Passivbauteile. Der Anschluss erfordert ein langes Einweichen und eine anhaltende Maximaltemperatur. Das Programmieren des Ofens dafür garantiert, dass die Passivbauteile Übergekocht werden. Das Zurückfahren des Profils zum Schutz der Passivbauteile garantiert kalte Lötstellen am Anschluss.

Die Fehler sind vorhersehbar. Tombstoning tritt auf, wenn ein Ende eines Passivs vor dem anderen reflowt, was die Oberflächenspannung ausnutzt, um es vertikal zu ziehen—ein direktes Ergebnis eines zu aggressiven Profils für Bauteile mit niedriger Masse. Kalte Lötstellen an großen Komponenten sind das Gegenstück: Die thermische Masse des Bauteils hat alle Hitze aufgenommen, bevor das Lot das Bein richtig benetzen konnte. Die Behebung eines Fehlers führt zuverlässig zum anderen. Dies ist kein Einstellproblem; es ist eine grundlegende Nichtübereinstimmung zwischen dem Ein-Kurve-Paradigma und der thermischen Realität.

Die Data-Logged-Profiling-Disziplin

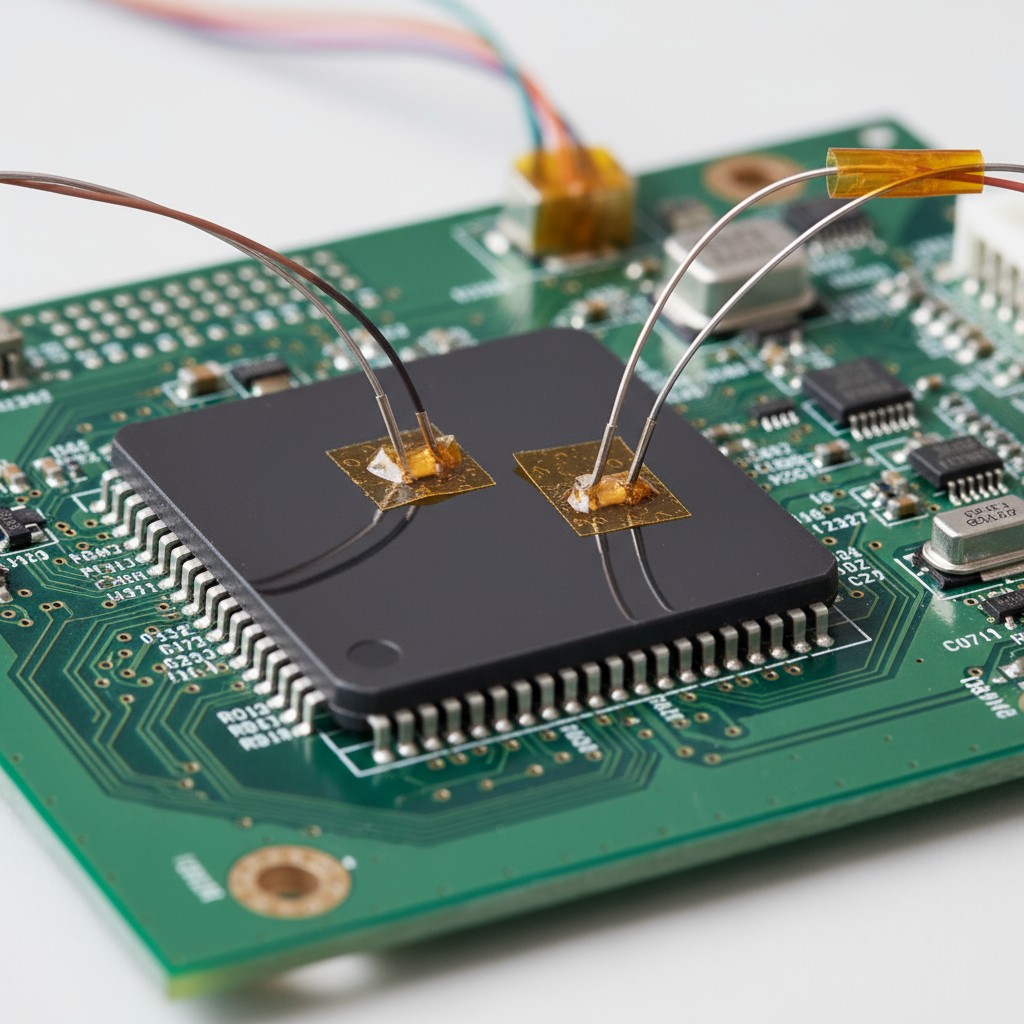

Die Alternative zum Annahme, ein Profil werde funktionieren, ist, es zu messen, ob es das tut. Daten-geloggtes Profiling befestigt Temperaturfühler direkt an den Komponenten an den thermischen Extremen der Leiterplatte: die größte, massereichste Komponente und die kleinste, leichteste Komponente. Das Durchlaufen der Leiterplatte durch den Ofen zeichnet die tatsächliche Temperatur auf, die jede Komponente im Laufe der Zeit erfährt. Das gibt Ihnen eine Faktenauflistung darüber, was geschieht, und keine theoretische Vorhersage.

Der Wert liegt hier nicht in einer schöneren Kurve. Es ist die unmissverständliche Offenbarung, wann Prozessfenster verletzt werden. Wenn die Daten zeigen, dass das kleine Passive 250°C erreicht, während der große Stecker noch bei 210°C kämpft, hört das Rätselraten auf. Der Konflikt wird quantifiziert. Die Entscheidung wird eine Priorisierung. Oft muss das schwere Bauteil das Profil diktieren, und die leichteren Komponenten müssen durch andere Mittel geschützt werden, wie Leiterplattenplatzierung oder Zonen-Voreinheitung.

Daten-geloggtes Profiling sprengt auch das falsche Selbstvertrauen, das durch Messen der Lufttemperatur des Ofens oder das Verwenden einer nackten Leiterplatte entsteht. Die Lufttemperatur sagt Ihnen, was der Ofen macht, nicht was die Komponenten fühlen. Eine nackte Leiterplatte hat keine thermische Massevarianz, was ihr Profil zu einer idealisierten Fiktion macht. Nur die Messung auf Komponentenebene erfasst die Wahrheit. Diese Disziplin erfordert eine Anfangsinvestition, aber die Kosten werden beim ersten Mal, wenn eine NPI keine fünf Iterationsläufe benötigt, wieder hereingeholt.

Die Stickstofffrage, die niemand richtig stellt

Stickstoffatmosphäre während des Reflows wird mit bemerkenswerter Konstanz spezifiziert und selten hinterfragt. Die Annahme ist, dass eine inert Umgebung immer besser ist. Die Realität ist bedingter. Stickstoff hemmt die Oxidation von geschmolzenem Lot, was nur dann vorteilhaft ist, wenn die Flusschemie zu schwach ist, um die Arbeit allein zu erledigen, oder wenn die Oberfläche der Leiterplatte besonders empfindlich ist.

Wenn Stickstoff tatsächlich eine Rolle spielt: No-Clean-Flüsse haben eine geringere chemische Aktivität. Bei Oberflächen wie blankem Kupfer oder ENIG, bei denen Oxide sich schnell bei Reflow-Temperaturen bilden, kann das Flussmittel die Oberfläche möglicherweise nicht vor dem Benetzen reinigen. Hier bietet Stickstoff eine bedeutende Prozessmarge.

Wenn Stickstoff Verschwendung ist: Aggressive, wasserlösliche Flüsse sind dafür konzipiert, Oxide zu durchdringen. Das Betreiben unter Stickstoff bringt keinen Vorteil. Ebenso sind Heißluft-Lötflächen (HASL) von Natur aus oxidefrei und profitieren nicht von einer inertem Atmosphäre. Die Spezifikation von Stickstoff in diesen Fällen erhöht die Kosten und Komplexität ohne messbaren Nutzen.

Die Frage ist nicht, ob Stickstoff gut ist, sondern ob Ihre spezifische Kombination aus Flussmittel und Oberflächenfinish eine Oxidationsherausforderung darstellt, die das Flussmittel nicht allein bewältigen kann. Dies ist eine Materialtechnik-Entscheidung, kein genereller Standard.

One-and-Done-Ofen-Mapping

Das Ofenkartierung charakterisiert die Temperaturgleichmäßigkeit und den Luftstrom Ihres Ofens. Ein Testboard mit Gitter aus Thermoelementen wird durch den Prozess geführt und zeigt heiße und kalte Zonen über den Förderband. Diese Daten ermöglichen es, Leiterplatten an der optimalen Position zu platzieren und die Zoneneinstellungen anzupassen, um die einzigartige thermische Signatur des Ofens auszugleichen.

Die Disziplin besteht darin, dies gründlich zu tun, einmalig, und die daraus resultierenden Daten als Grundlage für alle weiteren Arbeiten zu verwenden. Die Karte wird nicht für jedes neue Board wiederholt. Stattdessen informiert sie das anfängliche Profil für jeden NPI. Du weißt bereits, dass die linke Seite des Förderbands 10 Grad heißer läuft als die rechte, also machst du die Anpassung, bevor das erste Board überhaupt hinein kommt.

Dies eliminiert die iterative Wiederentdeckung der Eigenarten des Ofens. Es macht die Ofencharakterisierung zur Voraussetzung, nicht zum Nachgedanken. Die Zeit, die in eine umfassende Kartierungsstudie investiert wird, sind einige Stunden. Die über ein Jahr an NPIs gesparte Zeit entspricht Wochen.

Entwicklung eines Profiling-Protokolls, das die Physik respektiert

Das Ablehnen der Lehrbuchorthodoxie zugunsten der Messung führt zu einem Protokoll, das die Datenerfassung vorab plant. Es zielt nicht auf eine perfekte Kurve ab. Es zielt auf ein Prozessfenster ab, das akzeptable Lötstellen an jedem Bauteil liefert — ein anderes und erreichbares Ziel.

Das Protokoll:

- Karte den Ofen. Wenn es noch nicht gemacht wurde, charakterisiere die thermische Homogenität. Dokumentiere Hotspots, Coldspots und Zonendifferenzen.

- Identifiziere thermische Extreme. Wähle die größte, schwerste und die kleinste, leichteste Komponente auf deinem Board. Das sind deine Wächter.

- Befestige Temperatursensoren. Rüste die Wächterkomponenten aus und fahre das Board mit einem Anfangsprofil, das auf Pastendaten und deiner Ofenkarte basiert.

- Überprüfe die Daten. Überprüfe die protokollierten Temperaturkurven. Sind beide Wächter innerhalb ihrer Prozessfenster geblieben? Falls nicht, passe die Zonen-Setpoints oder die Fördergeschwindigkeit an.

- Bestätigen. Führe ein weiteres Profil mit den angepassten Einstellungen durch, um sicherzustellen, dass beide Wächter innerhalb der Spezifikation sind.

- Validieren. Untersuchen Sie die Lötstellen an den Sentinel-Boards und einer Probe anderer Komponenten. Wenn sie akzeptabel sind, sperren Sie das Profil. Wenn Mängel bleiben, ist das Problem nicht das Profil; es handelt sich um ein upstream-Designproblem, das durch mehr Iterationen nicht gelöst wird.

Dieses Protokoll verwendet reale Daten, um Entscheidungen zu treffen, und beschränkt die Iterationsschleife auf eine einzige Bestätigungsrunde. Die eingesparte Zeit ist die direkte Folge davon, auf Rätsel zu verzichten, wann man messen kann.